Réparation d'un volume en panne sur Synology

Nous allons voir ici les commandes nécessaires à la réparation d'un volume en panne sur un serveur Synology en DSM 6.x.

Cela peut se produire à cause d'un disque défectueux ou dans bien d'autres situations

- Connexion au serveur via un terminal

ssh user@192.168.50.50- Passage en root

sudo -i- On regarde l'état des volumes

> cat /proc/mdstat

Personalities : [linear] [raid0] [raid1] [raid10] [raid6] [raid5] [raid4] [raidF1]

md2 : active raid1 sdb3[0](E)

129395712 blocks super 1.2 [1/1] [E]

md3 : active raid1 sdc3[0]

12880079872 blocks super 1.2 [1/1] [U]

md1 : active raid1 sdb2[0] sdc2[1]

2097088 blocks [12/2] [UU__________]

md0 : active raid1 sdc1[1]

2490176 blocks [12/1] [_U__________]

unused devices: <none>

- On demande plus de détails sur le volume en panne avec 'mdadm'

> mdadm --detail /dev/md2

/dev/md2:

Version : 1.2

Creation Time : Sat Feb 6 14:48:56 2021

Raid Level : raid1

Array Size : 129395712 (123.40 GiB 132.50 GB)

Used Dev Size : 129395712 (123.40 GiB 132.50 GB)

Raid Devices : 1

Total Devices : 1

Persistence : Superblock is persistent

Update Time : Mon Jan 31 00:16:47 2022

State : clean, FAILED

Active Devices : 1

Working Devices : 1

Failed Devices : 0

Spare Devices : 0

Name : DS3617XS:2 (local to host DS3617XS)

UUID : f59e002f:993fea26:7771e2ae:6d8cf5a5

Events : 234

Number Major Minor RaidDevice State

0 8 19 0 faulty active sync /dev/sdb3

- On regarde ce que comporte "md2" comme partitions montées sur le système

mount | grep md2

On peut voir qu'il comporte le 'volume1' et qu'il est en lecture seule

- On force le démontage de ce 'volume1' avant de manipuler 'mdadm'

umount -l /volume1

- On stop les tâches en cours

syno_poweroff_task -d

- On stoppe le service 'mdadm' sur 'md2'

mdadm --stop /dev/md2

- On réassemble l'array 'md2' en supprimant le flag 'FAULTY'

> mdadm --assemble --scan --force

mdadm: clearing FAULTY flag for device 0 in /dev/md/2 for /dev/sdb3

mdadm: Marking array /dev/md/2 as 'clean'

mdadm: /dev/md/2 has been started with 1 drive.

mdadm: Found some drive for an array that is already active: /dev/md/0_0

mdadm: giving up.

> mdadm --detail /dev/md2

/dev/md2:

Version : 1.2

Creation Time : Sat Feb 6 14:48:56 2021

Raid Level : raid1

Array Size : 129395712 (123.40 GiB 132.50 GB)

Used Dev Size : 129395712 (123.40 GiB 132.50 GB)

Raid Devices : 1

Total Devices : 1

Persistence : Superblock is persistent

Update Time : Mon Jan 31 22:42:59 2022

State : clean

Active Devices : 1

Working Devices : 1

Failed Devices : 0

Spare Devices : 0

Name : DS3617XS:2 (local to host DS3617XS)

UUID : f59e002f:993fea26:7771e2ae:6d8cf5a5

Events : 236

Number Major Minor RaidDevice State

0 8 19 0 active sync /dev/sdb3

- On remonte tous les volumes

mount -a

- On vérifie que le 'volume1' soit bien monté et en 'rw'

mount | grep md2

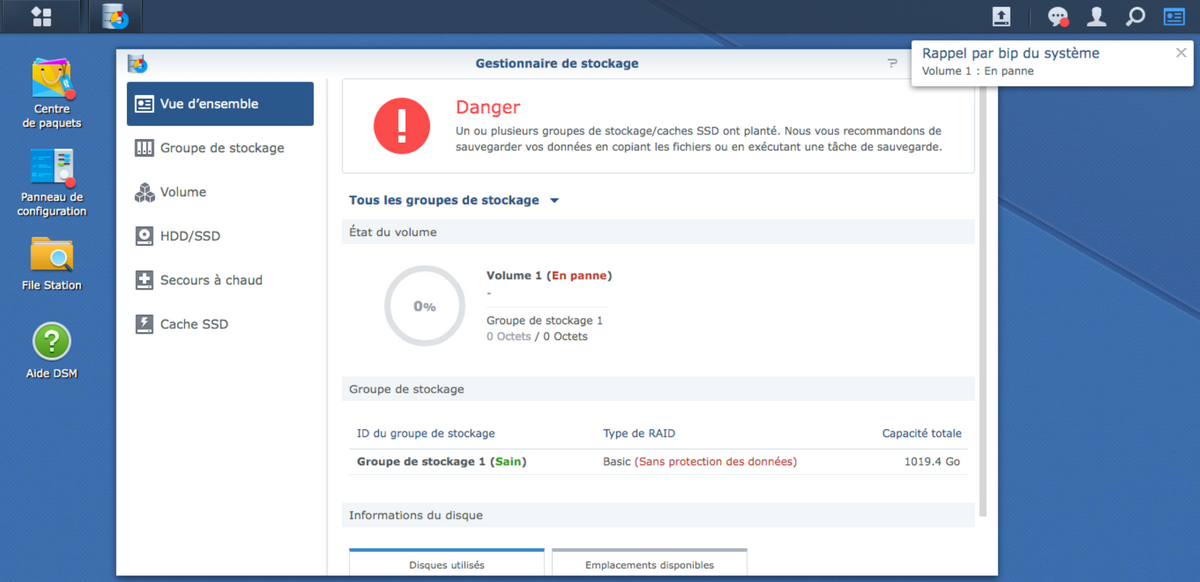

- Si un message comme celui-ci apparait :

vous pouvez cliquer sur réparer

Et pour finir vous vous retrouvez avec un volume 'Sain' et fonctionnel

Il ne vous reste plus qu'à faire un 'Reboot' de votre nas Synology via l'interface web ou en ligne de commande et c'est tout bon :)

reboot -f